動画像処理のMLモデルをデプロイする

準備

(1) ファイルのダウンロード

- sample.zip

ebstudio_sample_mediapipe_blank.json: チュートリアルで使用する作業用キャンバスのjsonファイルです。これをキャンバスにインポートします。ebstudio_sample_mediapipe_fin.json: 完成版のキャンバスです。最後に参照してください。sample.mov: サンプル用の動画ファイルです。

デフォルトの設定ではIPアドレスが公開状態になっています

- このサンプルファイルではWorkspace ws03 に配置されているエンドポイントへのアクセスを制限していません。

- サンプルを変更しカスタマイズしてご利用になる場合は、 IPアドレス制限の設定 を参照し、公開範囲を限定するように設定をしてください。

(2) StudioAppへアクセス

以下のURLにアクセスしてください。<env-name> はご自身のものに書き換えてください。

https://app.<env-name>.studio.exabase.ai/

# <env-name>が不明な場合は貴社内のご担当者さまへお問い合わせください。

チュートリアル

1. 新規プロジェクトを作成しJSONファイルをインポート

- StudioAppの

+新しいプロジェクトボタンから新しいプロジェクトを作成します(プロジェクト名は自由に設定してください)。 - ダウンロードしたJSONファイルをキャンバスにインポートします。

2. キャンバスで設計内容を確認

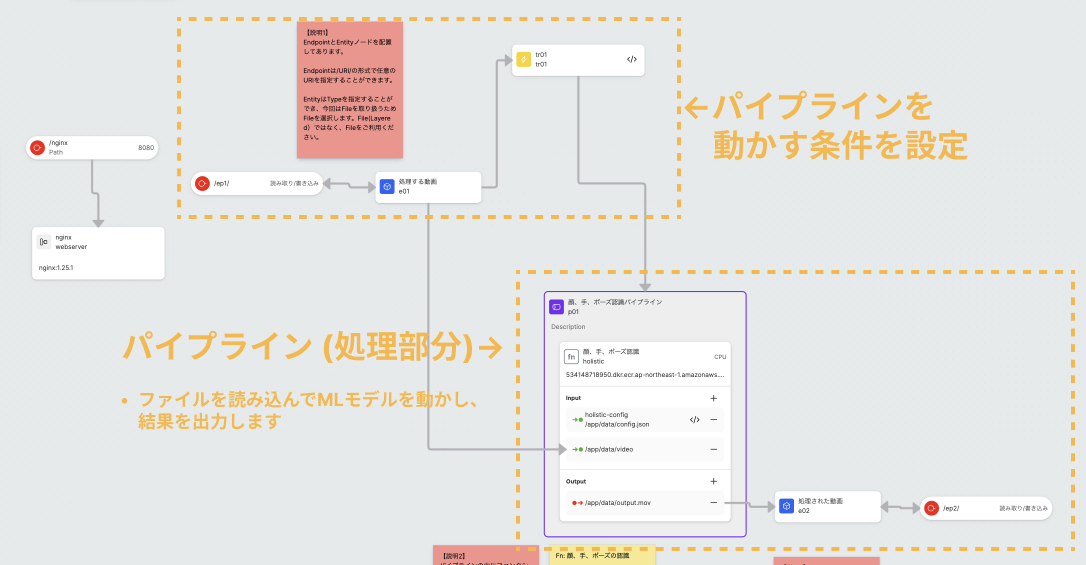

今回のキャンバスは大きく2つの部分で構成されています。

- 処理をキックする部分: 外部のデータを見て、条件に応じて処理をキックします。

- 処理の部分: データを読み込んでMLモデルを実行します。

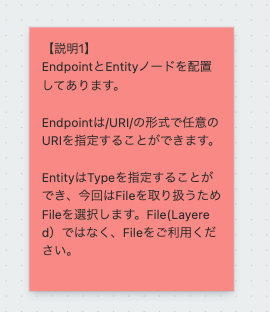

詳しくは、キャンバス上の付箋で解説していますのでご確認ください。

3. 処理をキャンバス上で実装する

具体的な実装方法は、キャンバス上の付箋の内容を参照してください。

- チュートリアルでは、処理部分(パイプライン)の中身を実装します。

- (1)

FileEntity e01に格納されたファイルの参照情報を利用して動画ファイルを取得 - (2) 顔、手、ポーズの認識

- (3)

FileEntity e02に処理結果をストレージにアップロード

- (1)

- 処理に使うMLモデル等はAWS ECR上に既にアップしているImageを使用します。Functionノードのimage URIから利用するイメージを指定します。

4. デプロイ

- 画面右上の

デプロイボタンを押してデプロイします。

5. 動画処理を実行

- デプロイが成功したらSideAppに接続されているEndpointを選択し、右パネルに表示されているURLから動画のアップロード/ダウンロードを行うページへアクセスして、動画をアップロードします。

6. 実行結果を確認

- 処理が完了すると画面上のFileIdに値が入り、ダウンロードリンクが作成されます。リンクから動画ファイルをダウンロードし、正常に処理されていることを確認してください。

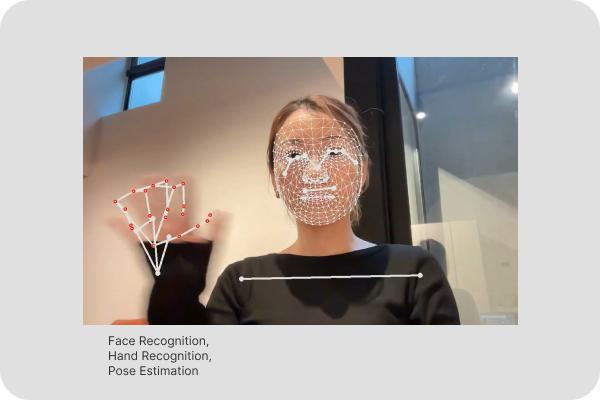

- 正常に処理が行われると、以下のような動画が生成されます。

(参考)ご自身のモデルを使う方法

- 自前のモデルや関数を追加する をご覧ください。